МОДА

Зонты с логотипом — описание, достоинства, применение, особенности

Зонты с логотипом дополняют и углубляют визуальное восприятие вашего бренда, подробнее о них на сайте https://greengo-krd.ru/services/zonty. Они являются маркетинговым инструментом, который может привлекать внимание...

КРАСОТА

ДОМ

ОТНОШЕНИЯ

Что такое реалистичные секс-куклы для женщин? Виды, описания, достоинства

Давно ли Вам стало любопытно, как современные технологии позволяют сделать шаг вперед в области интимных отношений? За последние годы, на рынке появилось удивительное устройство,...

Банкетные залы в Москве для свадьбы: идеальный выбор для незабываемого торжества

Свадьба - одно из самых значимых и долгожданных событий в жизни каждой пары. Каждая деталь этого особого дня должна быть продумана и организована с...

Романтическая ночь в Москва-сити: преимущества услуги

Москва-сити — своего рода символ столицы России, место, где современные высотные здания соседствуют с историческими памятниками. Среди многочисленных достопримечательностей Москва-сити предлагает возможность провести незабываемую...

СЕМЬЯ

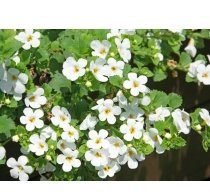

Ампельные петунии: описание цветка, выращивание и уход

Стремясь окружить себя красотой и создать уют в своем доме или саду, многие садоводы и цветоводы обращают внимание на ампельные петунии. Эти растения, пользующиеся...

Вокал для взрослых — с чего начать, этапы обучения, когда видны...

Вокал - это искусство, способное завораживать и трогать сердца. Многие взрослые люди мечтают научиться петь, но не знают, с чего начать. Есть несколько важных...

Речные круизы из Санкт-Петербурга: обзор популярных направлений и советы для подготовки...

Санкт-Петербург, бывшая столица и культурная столица России, может похвастаться огромным количеством достопримечательностей и удивительной атмосферой. Один из лучших способов насладиться красотой и шармом города...

ЗДОРОВЬЕ

Болезнь Альцгеймера — причины, симптомы, диагностика и лечение

Научные исследования показали, что наличие определенных генов может повышать риск развития болезни Альцгеймера, о ней подробнее тут. В частности, мутации генов APP, PSEN1 и...

Кто логопед и как выбрать его для ребенка

Когда речь заходит о важности своевременного и грамотного развития речи у детей, невозможно обойти вниманием одну из основных фигур, влияющую на процесс формирования языковых...

Болит зуб, когда обратиться к стоматологу и как выбрать специалиста

Забыть о повседневных заботах и насладиться каждым моментом жизни – это то, о чем мы мечтаем. Однако, даже самые прекрасные моменты зачастую могут быть...